Voici comment vous allez utiliser l’IA avec Google

Recherche web améliorée grâce à l’intelligence artificielle (IA), assistant vocal personnel capable de discuter d’une façon plus naturelle, IA pour lunettes intelligentes… Google a dévoilé plusieurs outils où l’IA va pouvoir déployer son efficacité. Et transformer nos manières d’interagir avec le monde numérique.

L’intelligence artificielle (IA) entre partout. Pour preuve, elle était au centre de la présentation annuelle de Google pour sa conférence Google I/O, accessible dans le monde entier ce mardi 14 mai. Voici quatre annonces que la géante américaine vient de faire et qui vont bousculer, dans peu de temps, notre quotidien.

Mais comme une image vaut mille mots, dit l’adage, regardez d’abord ce petit vidéo proposé par Google : il permet de saisir comment l’IA va transformer l’utilisation que nous faisons de nos outils de recherche en ligne.

Gemini Live : une conversation plus naturelle avec l’IA

Google a lancé plus tôt cette année Gemini, un robot conversationnel qui se veut l’équivalent de ChatGPT, d’OpenAI.

L’application mobile Gemini permet déjà de poser des questions avec sa voix au robot conversationnel. Mais l’entreprise compte bientôt améliorer les fonctionnalités vocales de l’outil avec le lancement de Gemini Live. « Ça va permettre d’avoir une conversation en profondeur avec l’assistant », explique Sissie Hsiao, vice-présidente de Google, responsable de l’Assistant Google et de Gemini, lors d’une conférence de presse en marge de Google I/O.

Au lieu d’analyser une requête à la fois, Gemini Live est conçu pour être à l’écoute plus longtemps et discuter d’une manière plus réaliste. Il est, par exemple, possible de l’interrompre pendant qu’il parle et d’avoir une discussion à son rythme. Gemini Live pourrait ainsi être utilisé pour pratiquer un discours, ce qui n’est pas faisable avec Gemini dans sa forme actuelle.

Gemini Live sera lancé dans les prochains mois pour les utilisateurs payants de Gemini.

Notons qu’OpenAI, l’entreprise derrière ChatGPT, vient aussi de dévoiler GPT-4o, son nouveau modèle de langage qui permet également d’avoir des interactions plus naturelles avec son robot conversationnel.

Project Astra : une IA pour lunettes intelligentes

La présentation la plus impressionnante de Google I/O est l’IA Project Astra, un robot conversationnel capable d’interpréter le son, les images et les vidéos en temps réel.

Astra sera à même « de voir et d’entendre la même chose que nous, de mieux comprendre le contexte dans lequel nous nous trouvons et de nous répondre rapidement dans une conversation, rendant l’interaction naturelle », déclare Demis Hassabis, directeur général de DeepMind, la division de Google spécialisée en IA.

Dans sa présentation vidéo, Google a montré son outil en train de répondre à des questions comme « qu’est-ce que c’est, cette partie du haut-parleur ? » ou encore « où ai-je mis mes lunettes ? », pendant qu’une personne filmait devant elle avec son téléphone.

Astra devrait être offert plus tard cette année dans l’application mobile Google Gemini. Avec le temps, Astra devrait aussi être intégré à des lunettes intelligentes, selon Google, mais aucun modèle compatible n’a été annoncé pour l’instant.

Project Astra rappelle d’ailleurs Meta AI, de Meta, qui permet de prendre une photo (mais pas des vidéos en temps réel) avec les lunettes intelligentes Ray-Ban Meta et de poser une question avec sa voix.

Des modèles d’IA plus puissants

- L’IA IMAGEN 3 permettra de générer des images plus réalistes, comme celle de ce loup… numérique. Photo : Google.

Google a aussi profité de la conférence pour annoncer des mises à jour de la plupart de ses modèles d’IA, comme son IA génératrice d’images IMAGEN 3 qui permet désormais de créer de fausses photos plus réalistes qu’auparavant.

L’entreprise a également annoncé l’arrivée du modèle Gemini 1.5 Pro pour les utilisateurs payants de Gemini. Le modèle, offert aux développeurs depuis quelques semaines, permet notamment d’analyser des photos, de l’audio et des vidéos, en plus du texte.

Google a, de plus, dévoilé Veo, un nouveau modèle d’IA qui permettra de générer des vidéos avec une résolution 1080p à partir d’une requête textuelle (par exemple « une vidéo d’une minute d’une vue aérienne d’un phare sur le bord de mer »). Il s’agit de l’équivalent de Sora, d’OpenAI, qui avait retenu l’attention lors de son dévoilement en début d’année.

Veo sera offert en premier à certains utilisateurs, comme c’est le cas de Sora à l’heure actuelle, et devrait par la suite être intégré à différents produits de Google, par exemple la plateforme de courtes vidéos YouTube Shorts.

Une nouvelle recherche à l’IA

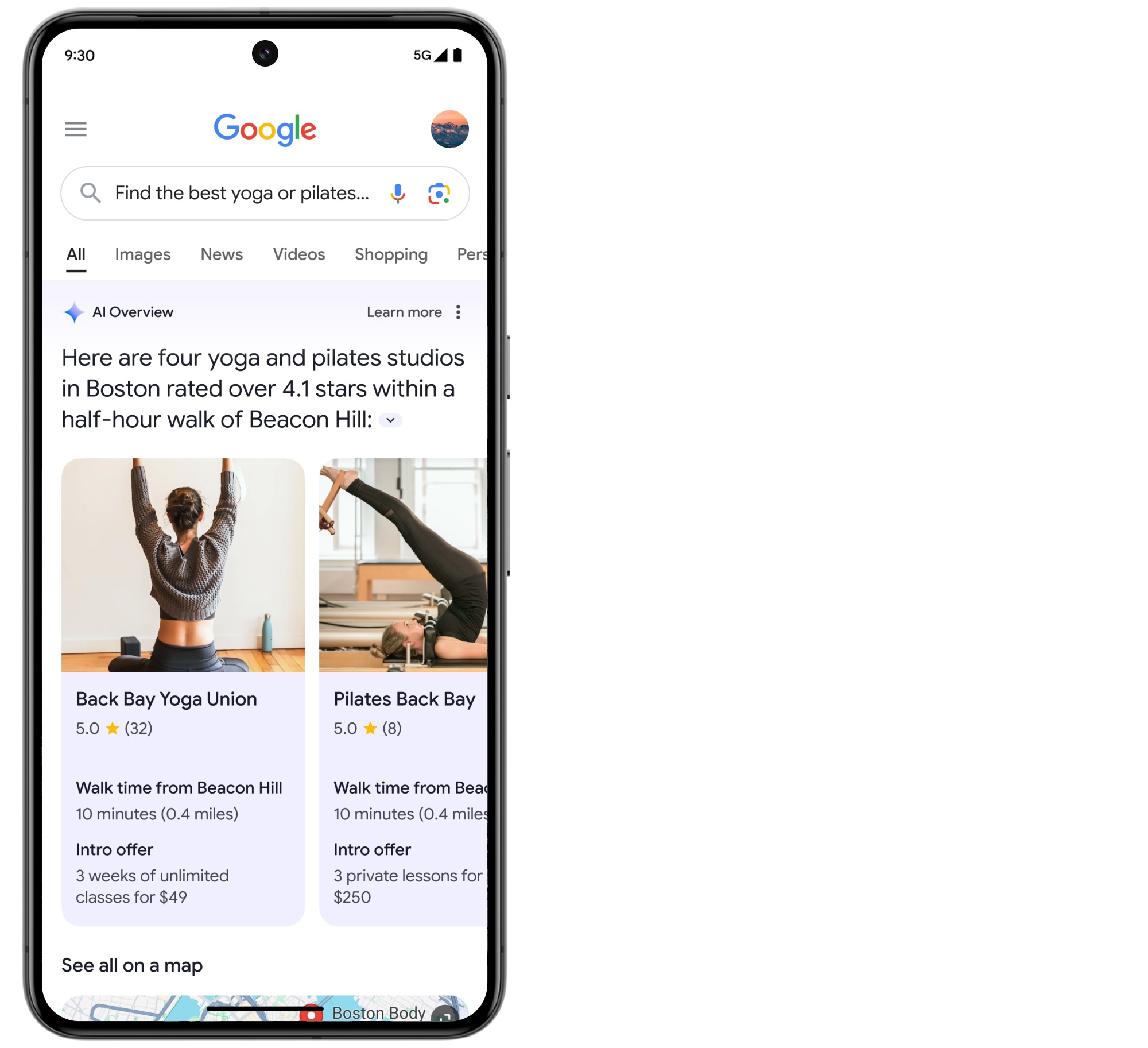

- L’arrivée de l’IA générative permettra de poser des questions plus complexes à Google. Photo : Google.

Google a profité de sa conférence annuelle I/O pour présenter les nouvelles façons dont l’IA générative sera utilisée dans le but d’améliorer des résultats de recherche.

L’entreprise aurait déjà mis à l’essai la recherche à l’aide de l’IA générative à travers les milliards de requêtes d’utilisateurs, ce qui lui a permis de mieux comprendre quand l’IA est utile ou quand, au contraire, elle n’améliore pas l’expérience. « Si la méthode actuelle fonctionne bien, nous n’allons pas la modifier », explique Liz Reid, vice-présidente de Google responsable de Google Search. L’IA générative ne sera donc pas utilisée par Google dans chacune de vos recherches.

L’une des fonctionnalités d’IA qui sera parfois présentée aux utilisateurs est AI Overview (qu’on pourrait traduire par « aperçu à l’IA »), qui rédige une longue réponse à une question en incluant des liens vers différents articles (l’équivalent de l’outil Bing Copilot, de Microsoft).

Google offrira aussi d’autres fonctionnalités à l’IA, comme la possibilité de mieux présenter les résultats de la recherche. Par exemple, si vous cherchez un restaurant, les résultats pourraient être présentés selon l’outil pourrait vous en présenter selon le type d’occasion souhaitée. Il sera également possible de poser des questions plus complexes au moteur de recherche Google qui nécessiteraient normalement plusieurs questions différentes (par exemple « trouve les meilleurs studios de yoga ou de pilates, affiche leurs promotions pour les nouveaux cours et indique-moi à quelle distance de marche de chez moi ils se situent »).

La recherche à l’IA sera intégrée à d’autres produits Google, comme Google Photos. Il sera alors facile d’effectuer des recherches plus complexes qu’à l’heure actuelle, en posant des questions comme « quel était le numéro d’immatriculation de mon automobile il y a dix ans? », ou « crée un montage de ma fille en train d’apprendre la natation au fil des ans ».

Ces fonctionnalités d’IA seront d’abord disponibles aux États-Unis, puis dans d’autres pays aussi la fin de l’année. La date où ces nouveaux outils seront offerts au Canada n’a pas été confirmée. Google devrait rejoindre un milliard d’utilisateurs d’ici 2025 avec AI Overview.

À lire aussi : ChatGPT : ne lui laissez pas d’informations personnelles

- Image principale: Le directeur général de google Sundar Pichai, à la conférence pour développeurs Google I/O 2024. Photo : Google.

Des proches aidants pourraient recevoir environ 21 $ l’heure, pour un no...

Des biscuits pour nourrisson à l’arrow-root Gerber sont rappelés partout...

Du 6 au 22 février 2026, les Jeux olympiques de Milan-Cortina rassembler...

Plus de 8 500 Volkswagen ID.4 font l’objet d’un rappel de Transports Can...

L'envoi de commentaires est un privilège réservé à nos abonnés.

Déjà abonné? Connectez-vous

Il n'y a pas de commentaires, soyez le premier à commenter.